霍金:人工智能风险巨大

核心提示:英国《独立报》网站5月1日刊登题为《霍金说:“<超验骇客>探讨了人工智能的影响,但我们对人工智能足够重视吗?”》一文。作者为剑桥大学教授斯蒂芬·霍金、加利福尼亚大学伯克利分校教授斯图尔特·拉塞尔、麻省理工学院教授马克斯·特格马克、2004年诺贝尔物理学奖获得者、麻省理工学院教授弗兰克·维尔切克。

英国《独立报》网站5月1日刊登题为《霍金说:“<超验骇客>探讨了人工智能的影响,但我们对人工智能足够重视吗?”》一文。作者为剑桥大学教授斯蒂芬·霍金、加利福尼亚大学伯克利分校教授斯图尔特·拉塞尔、麻省理工学院教授马克斯·特格马克、2004年诺贝尔物理学奖获得者、麻省理工学院教授弗兰克·维尔切克。

好莱坞大片《超验骇客》正在上映,约翰尼·德普和摩根·弗里曼在片中展示了对人类未来相互冲突的看法。人们大多会把高度智能机器概念当成纯粹的科幻,但这是错误的,有可能是历史上最严重的错误。

人工智能(AI)研究现正迅速发展。近来的里程碑(如无人驾驶汽车、计算机在《危险边缘》智力竞赛节目中获胜、数字私人助手Siri、Google Now和语音助手Cortana等)不过是史无前例的投资激发信息技术军备竞赛的征兆。与今后几十年会出现的事物相比,这些成就大概微不足道。

潜在的好处很多。文明所能提供的一切都是人类智慧的产物,人类无法预言当这种智慧被AI能提供的工具放大时人类能实现什么,但消除战争、疾病和贫困将是所有人都最盼望的。成功创造AI将是人类历史上最重大的事件。

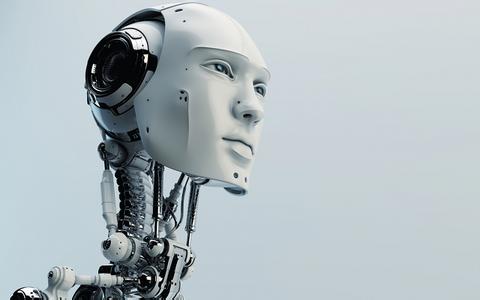

人工智能

遗憾的是,如果人类不学会避开风险,那它也可能是最后的事件。在近期,世界各国军队都在考虑能选择和消灭目标的自主武器系统;在中期,正如埃里克·布林约尔松和安德鲁·麦卡菲在《第二次机器时代》一书中所强调的,AI也许会改变人类的经济,既带来巨大财富,也带来巨大混乱。

再往前看,能实现的东西没有根本性极限:没有物理定律阻止粒子以某种方式组织起来,从而能比人脑中的粒子组合完成更高级的计算。爆炸性转变是可能发生的,但其过程也许会不同于电影情节:正如欧文·古德在1965年认识到的,具有超越人类智能的机器会不断进一步改善自身设计,引发韦尔诺·温格所称的“奇点”和约翰尼·德普在影片中扮演的人物所称的“超验”。

人们可以想像这种技术智胜金融市场,发明能力超过人类研究者,操控能力超过人类领袖,开发出我们根本弄不懂的武器。虽然AI在短期内的影响取决于谁来控制,但长期影响取决于它还能否受到控制。

因此,面对收益和风险都不可估量的未来,专家们肯定在想尽一切办法确保最佳结局,对吗?错了。就AI而言,虽然人类将遭遇历史上有可能最好也可能最坏的事情,但除了剑桥大学生存风险研究中心、人类未来研究所、机器智能研究所和未来生活研究所等非营利性研究机构以外,没什么人对这些问题进行认真研究。所有人都应当问问自己现在能做些什么来提高获得收益而避开风险的可能性。

[责任编辑:李航行]